TPU (Tensor Processing Unit), lo nuevo de Google

Machine learning —una rama de la inteligencia artificial (IA) que estudia el reconocimiento de patrones y el aprendizaje computacional— está en la base de muchos de los productos de Google, desde la búsqueda por voz en Mapas hasta el reconocimiento de imágenes.

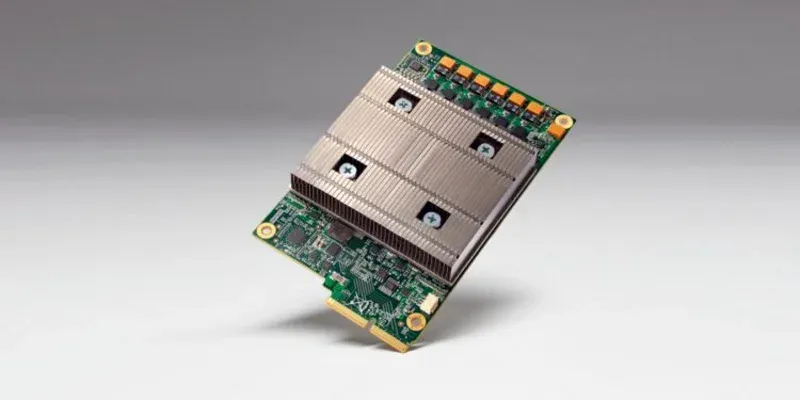

Sin embargo, Google también sostiene que "un gran software brilla más con un gran hardware". Es por esto que, en los últimos años, la compañía ha trabajado en un ASIC (circuito integrado de aplicación específica) llamado Tensor Processing Unit (TPU).

El objetivo, según el gigante de las búsquedas, es "ver lo que se podría lograr con aceleradores personalizados para aplicaciones de machine learning".

La TPU ha estado funcionando dentro de los centros de datos de la empresa desde hace más de un año, entregando procesos más eficientes con el mismo nivel de energía que otros desarrollos basados en inteligencia artificial.

Si eso no suena impresionante, para poner esto en perspectiva, Google dice que la mejora es equivalente a adelantar la tecnología aproximadamente siete años en el futuro, o tres generaciones de la Ley de Moore.

En última instancia, todo se reduce a la optimización: con un menor número de transistores por operación requerida, más operaciones pueden ejecutarse, por lo que todas las operaciones basadas en machine learning son notablemente más rápidas.

La placa en sí también logra ser compacta y funcional, de modo que una TPU cabe fácilmente en la ranura de un disco duro utilizado en sus centros de datos.

El equipo también está orgulloso de la rapidez con que logró convertir esta idea en una realidad: les tomó solo 22 días contar con una unidad funcional, lo cual es realmente impresionante.